Hive是一个构建在Hadoop之上的数据仓库。它可以将结构化的数据文件映射成表,并提供类

SQL查询功能。

- 用于查询的

SQL语句会被转化为MapReduce作业,然后提交到Hadoop上运行。

数据类型

CREATE TABLE students(

name STRING, -- 姓名

age INT, -- 年龄

subject ARRAY<STRING>, --学科

score MAP<STRING,FLOAT>, --各个学科考试成绩

address STRUCT<houseNumber:int, street:STRING, city:STRING, province:STRING> --家庭居住地址

) ROW FORMAT DELIMITED FIELDS TERMINATED BY "\t";

| 大类 | 类型 |

|---|---|

| Integers(整型) | TINYINT—1 字节的有符号整数 SMALLINT—2 字节的有符号整数 INT—4 字节的有符号整数 BIGINT—8 字节的有符号整数 |

| Boolean(布尔型) | BOOLEAN—TRUE/FALSE |

| Floating point numbers(浮点型) | FLOAT— 单精度浮点型 DOUBLE—双精度浮点型 |

| Fixed point numbers(定点数) | DECIMAL—用户自定义精度定点数,比如 DECIMAL(7,2) |

| String types(字符串) | STRING—指定字符集的字符序列 VARCHAR—具有最大长度限制的字符序列 CHAR—固定长度的字符序列 |

| Date and time types(日期时间类型) | TIMESTAMP — 时间戳 TIMESTAMP WITH LOCAL TIME ZONE — 时间戳,纳秒精度 DATE—日期类型 |

| Binary types(二进制类型) | BINARY—字节序列 |

| 类型 | 描述 | 示例 |

|---|---|---|

| STRUCT | 类似于对象,是字段的集合,字段的类型可以不同,可以使用 名称.字段名 方式进行访问 |

STRUCT ('xiaoming', 12 , '2018-12-12') |

| MAP | 键值对的集合,可以使用 名称[key] 的方式访问对应的值 |

map('a', 1, 'b', 2) |

| ARRAY | 数组是一组具有相同类型和名称的变量的集合,可以使用 名称[index] 访问对应的值 |

ARRAY('a', 'b', 'c', 'd') |

隐式转换:

Hive中基本数据类型遵循以下的层次结构,按照这个层次结构,子类型到祖先类型允许隐式转换。例如

INT类型的数据允许隐式转换为BIGINT类型。

- 注意:按照类型层次结构允许将

STRING类型隐式转换为DOUBLE类型。

内容格式

当数据存储在文本文件中,必须按照一定格式区别行和列。

- 如使用逗号作为分隔符的

CSV文件或者使用制表符作为分隔值的TSV文件。但存在一个缺点,就是正常的文件内容中也可能出现逗号或者制表符。

所以

Hive默认使用了几个平时很少出现的字符,这些字符一般不会作为内容出现在文件中。

Hive默认的行和列分隔符如下表所示:

| 分隔符 | 描述 |

|---|---|

| \n | 对于文本文件来说,每行是一条记录,所以可以使用换行符来分割记录 |

| ^A (Ctrl+A) | 分割字段 (列),在 CREATE TABLE 语句中也可以使用八进制编码 \001 来表示 |

| ^B | 用于分割 ARRAY 或者 STRUCT 中的元素,或者用于 MAP 中键值对之间的分割, 在 CREATE TABLE 语句中也可以使用八进制编码 \002 表示 |

| ^C | 用于 MAP 中键和值之间的分割,在 CREATE TABLE 语句中也可以使用八进制编码 \003 表示 |

存储格式

Hive会在HDFS为每个数据库上创建一个目录,数据库中的表是该目录的子目录。

- 表中的数据会以文件的形式存储在对应的表目录下。

Hive支持以下几种文件存储格式:

| 格式 | 说明 |

|---|---|

| TextFile | 存储为纯文本文件。 这是 Hive 默认的文件存储格式。这种存储方式数据不做压缩,磁盘开销大,数据解析开销大。 |

| SequenceFile | SequenceFile 是 Hadoop API 提供的一种二进制文件,它将数据以<key,value>的形式序列化到文件中。这种二进制文件内部使用 Hadoop 的标准的 Writable 接口实现序列化和反序列化。它与 Hadoop API 中的 MapFile 是互相兼容的。Hive 中的 SequenceFile 继承自 Hadoop API 的 SequenceFile,不过它的 key 为空,使用 value 存放实际的值,这样是为了避免 MR 在运行 map 阶段进行额外的排序操作。 |

| RCFile | RCFile 文件格式是 FaceBook 开源的一种 Hive 的文件存储格式,首先将表分为几个行组,对每个行组内的数据按列存储,每一列的数据都是分开存储。 |

| ORC Files | ORC 是在一定程度上扩展了 RCFile,是对 RCFile 的优化。 |

| Avro Files | Avro 是一个数据序列化系统,设计用于支持大批量数据交换的应用。它的主要特点有:支持二进制序列化方式,可以便捷,快速地处理大量数据;动态语言友好,Avro 提供的机制使动态语言可以方便地处理 Avro 数据。 |

| Parquet | Parquet 是基于 Dremel 的数据模型和算法实现的,面向分析型业务的列式存储格式。它通过按列进行高效压缩和特殊的编码技术,从而在降低存储空间的同时提高了 IO 效率。 |

以上压缩格式中

ORC和Parquet的综合性能突出,使用较为广泛,推荐使用这两种格式。

内部表和外部表

内部表又叫做管理表,创建表时不做任何指定,默认创建的就是内部表。

想要创建外部表,则需要使用

External进行修饰。内部表和外部表主要区别如下:

| 内部表 | 外部表 | |

|---|---|---|

| 数据存储位置 | 内部表数据存储的位置由 hive.metastore.warehouse.dir 参数指定,默认情况下表的数据存储在 HDFS 的 /user/hive/warehouse/数据库名.db/表名/ 目录下 |

外部表数据的存储位置创建表时由 Location 参数指定 |

| 导入数据 | 在导入数据到内部表,内部表将数据移动到自己的数据仓库目录下,数据的生命周期由 Hive 来进行管理 | 外部表不会将数据移动到自己的数据仓库目录下,只是在元数据中存储了数据的位置 |

| 删除表 | 删除元数据(metadata)和文件 |

只删除元数据(metadata) |

分区表

Hive中的表对应为HDFS上的指定目录,在查询数据时候。

- 默认会对全表进行扫描,这样时间和性能的消耗都非常大。

分区为

HDFS上表目录的子目录,数据按照分区存储在子目录中。

- 如果查询的

where字句的中包含分区条件,则直接从该分区去查找,而不是扫描整个表目录。- 合理的分区设计可以极大提高查询速度和性能。

使用场景:

通常,在管理大规模数据集的时候都需要进行分区。

- 比如将日志文件按天进行分区,从而保证数据细粒度的划分,使得查询性能得到提升。

创建分区表:

在

Hive中可以使用PARTITIONED BY子句创建分区表。表可以包含一个或多个分区列,程序会为分区列中的每个不同值组合创建单独的数据目录。

CREATE EXTERNAL TABLE emp_partition(

empno INT,

ename STRING,

job STRING,

mgr INT,

hiredate TIMESTAMP,

sal DECIMAL(7,2),

comm DECIMAL(7,2)

)

PARTITIONED BY (deptno INT) -- 按照部门编号进行分区

ROW FORMAT DELIMITED FIELDS TERMINATED BY "\t"

LOCATION '/hive/emp_partition';

加载数据到分区表:

加载数据到分区表时候必须要指定数据所处的分区。

# 加载部门编号为20的数据到表中

LOAD DATA LOCAL INPATH "/usr/file/emp20.txt" OVERWRITE INTO TABLE emp_partition PARTITION (deptno=20)

# 加载部门编号为30的数据到表中

LOAD DATA LOCAL INPATH "/usr/file/emp30.txt" OVERWRITE INTO TABLE emp_partition PARTITION (deptno=30)

分桶表

并非所有的数据集都可以形成合理的分区,分区的数量也不是越多越好。

- 过多的分区条件可能会导致很多分区上没有数据。

同时

Hive会限制动态分区可以创建的最大分区数,用来避免过多分区文件对文件系统产生负担。鉴于以上原因,

Hive还提供了一种更加细粒度的数据拆分方案:分桶表 (Bucket Table)。分桶表会将指定列的值进行哈希散列,并对

bucket(桶数量)取余,然后存储到对应的bucket(桶)中。

创建分桶表:

在

Hive中,可以通过CLUSTERED BY指定分桶列,并通过SORTED BY指定桶中数据的排序参考列。

CREATE EXTERNAL TABLE emp_bucket(

empno INT,

ename STRING,

job STRING,

mgr INT,

hiredate TIMESTAMP,

sal DECIMAL(7,2),

comm DECIMAL(7,2),

deptno INT)

CLUSTERED BY(empno) SORTED BY(empno ASC) INTO 4 BUCKETS --按照员工编号散列到四个 bucket 中

ROW FORMAT DELIMITED FIELDS TERMINATED BY "\t"

LOCATION '/hive/emp_bucket';

分区表和分桶表结合使用:

分区表和分桶表的本质都是将数据按照不同粒度进行拆分,从而使得在查询时候不必扫描全表。

只需要扫描对应的分区或分桶,从而提升查询效率。

两者可以结合起来使用,从而保证表数据在不同粒度上都能得到合理的拆分。

索引

Hive在 0.7.0 引入了索引的功能,索引的设计目标是提高表某些列的查询速度。如果没有索引,带有谓词的查询(如

WHERE table1.column = 10)会加载整个表或分区并处理所有行。但是如果

column存在索引,则只需要加载和处理文件的一部分。

在指定列上建立索引,会产生一张索引表(表结构如下),里面的字段包括:

索引列的值、该值对应的

HDFS文件路径、该值在文件中的偏移量。在查询涉及到索引字段时,首先到索引表查找索引列值对应的

HDFS文件路径及偏移量,这样就避免了全表扫描。

+--------------+----------------+----------+--+

| col_name | data_type | comment |

+--------------+----------------+----------+--+

| empno | int | 建立索引的列 |

| _bucketname | string | HDFS 文件路径 |

| _offsets | array<bigint> | 偏移量 |

+--------------+----------------+----------+--+

索引的缺陷:

索引表无法自动

rebuild,也就意味着如果表中有数据新增或删除。

- 则必须手动

rebuild,重新执行MapReduce作业,生成索引表数据。

基本原理

基本架构

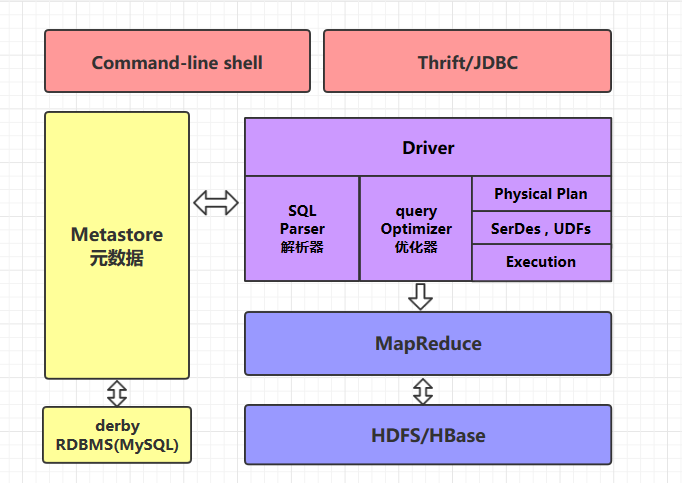

可以用

command-line shell和thrift/jdbc两种方式来操作数据:

- command-line shell:

- 通过 hive 命令行的的方式来操作数据。

- thrift/jdbc:

- 通过

thrift协议按照标准的JDBC的方式操作数据。

Metastore:

在

Hive中,表名、表结构、字段名、字段类型、表的分隔符等统一被称为元数据。所有的元数据默认存储在

Hive内置的derby数据库中,但由于derby只能有一个实例。

- 也就是说不能有多个命令行客户端同时访问,所以在实际生产环境中,通常使用

MySQL代替derby。

Hive进行的是统一的元数据管理,就是说在Hive上创建了一张表,然后在presto/impala/sparksql中都是可以直接使用。它们会从

Metastore中获取统一的元数据信息。

- 同样的你在

presto/impala/sparksql中创建一张表,在Hive中也可以直接使用。

执行流程

Hive在执行一条HQL的时候,会经过以下步骤:

语法解析:

Antlr定义SQL的语法规则,完成SQL词法,语法解析,将SQL转化为抽象 语法树AST Tree。语义解析:遍历

AST Tree,抽象出查询的基本组成单元QueryBlock。生成逻辑执行计划:

- 遍历

QueryBlock,翻译为执行操作树OperatorTree。优化逻辑执行计划:

- 逻辑层优化器进行

OperatorTree变换,合并不必要的ReduceSinkOperator,减少shuffle数据量。生成物理执行计划:

- 遍历

OperatorTree,翻译为MapReduce任务。优化物理执行计划:

- 物理层优化器进行

MapReduce任务的变换,生成最终的执行计划。

常用操作

查看数据列表:

show databases;

使用数据库:

USE database_name;

支付宝打赏

支付宝打赏  微信打赏

微信打赏