Ollama是一个基础于 Go 语言开发的可以本地运行大模型(LMM)的开源框架。

官方网站:https://ollama.com/

Ollama目前支持的大语言模型:https://ollama.com/library

Ollama与Llama的关系:

Llama是大语言模型,而Ollama是大语言模型(不限于Llama模型)便捷的管理和运维工具。

下载Ollama

https://ollama.com,进入网址,点击

Download下载。下载后直接安装即可。

启动配置模型

启动LLama3大模型或者启动千问大模型:

ollama run llama3

ollama run qwen2

常用命令

启动Ollama服务:

ollama server

模型会以服务的模式启动,默认运行端口为11434。

默认绑定地址为

127.0.0.1,即只可本机访问。

部署模型到本地:

ollama pull 模型名称:tag

注意:每个模型可能包含多个

tag,一般对应不同的参数规模。如果不指定

tag,则默认部署latest版本。

查看本地已部署的模型:

ollama list

删除本地模型:

ollama rm 模型name

运行模型:

ollama run 模型name

如果模型在本地不存在,则会先执行

pull,再run。运行成功后即可开启与模型的对话。

若要退出对话,输入

/bye即可。

查看当前正在运行的模型及状态:

ollama ps

停止模型运行:

ollama stop 模型name

或者在对话界面输入

/bye。

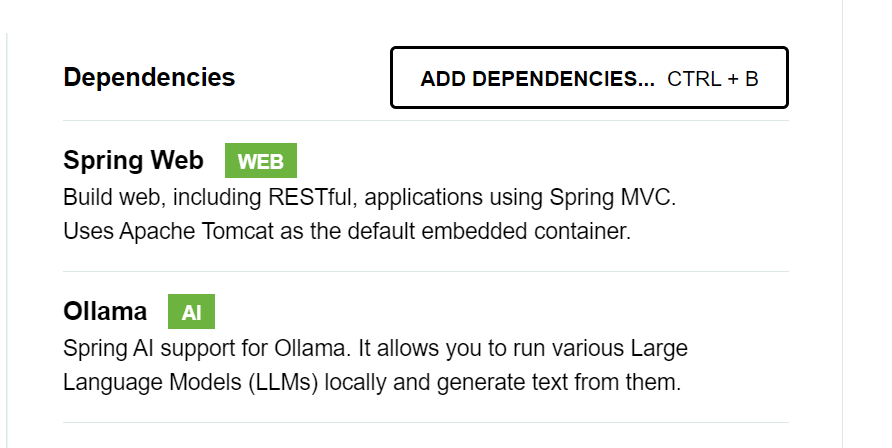

SpringBoot集成Ollama

通过

Spring Initializer进行初始化,选择Web和Ollama AI作为项目依赖。

支付宝打赏

支付宝打赏  微信打赏

微信打赏